0 or 1을 예측하는 것

혼동 행렬 (Confusion Matrix)

- 분류 문제에서 모델의 성능을 평가하는데 사용되는 표

- True Positive (TP): 실제로 참(True)인 값을 모델이 올바르게 참이라고 예측한 경우

- True Negative (TN): 실제로 거짓(False)인 값을 모델이 올바르게 거짓이라고 예측한 경우

- False Positive (FP): 실제로는 거짓(False)이지만 모델이 잘못해서 참(True)이라고 예측한 경우

- False Negative (FN): 실제로는 참(True)이지만 모델이 잘못해서 거짓(False)이라고 예측한 경우

| Recall / Precision | 참 (Positive) | 거짓 (Negative) |

| 참 (Positive) | True Positive (TP) | False Negative (FN) |

| 거짓 (Negative) | False Positive (FP) | True Negative (TN) |

평가 지표

- 정확도(Accuracy): 전체 예측 중 올바른 예측의 비율

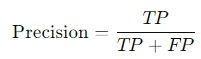

- 정밀도(Precision): 참으로 예측한 값 중 실제로 참인 비율 (ex: 코로나라고 예측한 사람 중 실제로 양성인 비율)

- 재현율(Recall, Sensitivity): 실제 참인 값 중에서 모델이 참으로 잘 예측한 비율 (ex: 코로나 환자들 중 양성이라고 예측한 비율)

- F1 점수(F1 Score): 정밀도와 재현율의 조화 평균

# import

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

from sklearn.metrics import confusion_matrix, classification_report

# prepare data

# make model

# fit model

# predict

# use

print(confusion_matrix(y_test, y_pred))

print(classification_report(y_test, y_pred))

'머신러닝' 카테고리의 다른 글

| 회귀 모델 평가 지표 (0) | 2024.10.04 |

|---|---|

| 회귀와 분류 (0) | 2024.10.02 |

| XAI 기반 GNN (0) | 2021.12.22 |